UberEats vs Deliveroo

Aujourd’hui nous nous intéressons aux applications de livraison de repas ou « food delivery« . Ces applications se sont multipliées ces trois dernières années. En France, deux leaders se partagent la majorité du marché : UberEats et Deliveroo. Nous avons décidé de comparer ces deux challengers afin de les confronter sur les critères suivants : leur consommation d’énergie, leur volume de données échangées ainsi que leur volume de mémoire occupée.

Dans le coin gauche UberEats, imaginée par les créateurs de Uber en Août 2014 et est disponible dans plusieurs pays du Monde, dans plus de 70 villes de l’Hexagone et ce 24h/24.

Dans le coin droit Deliveroo, une société britannique, créée en 2013 et principal concurrent de UberEats en France, couvrant plus de 45 villes françaises.

Ces deux applications vous permettent de commander et recevoir des repas livrés des restaurants proches de chez vous.

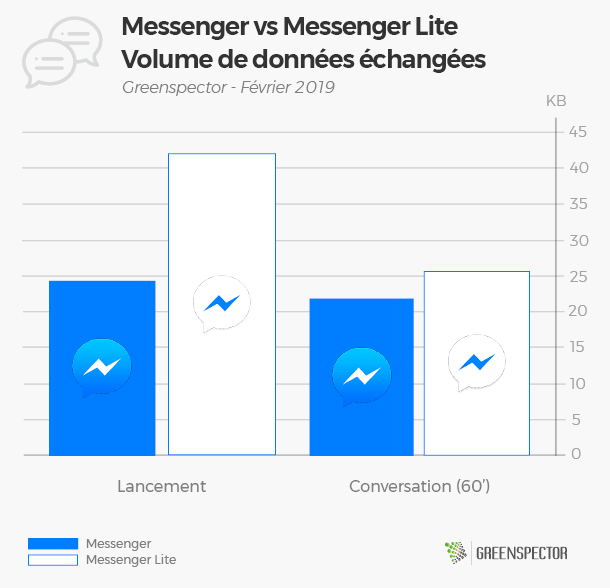

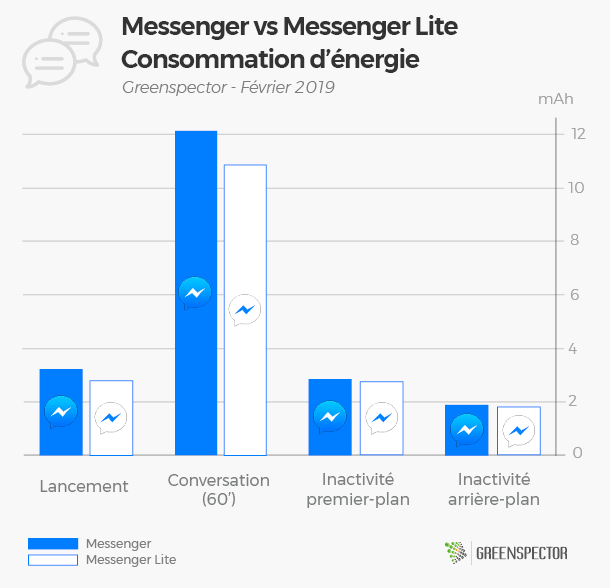

La pesée

Du point de vue du poids de l’application, Deliveroo est le poids plume. En effet, son poids (22 Mo) est 1.4 fois inférieur à celui de UberEats (31 Mo).

Le match

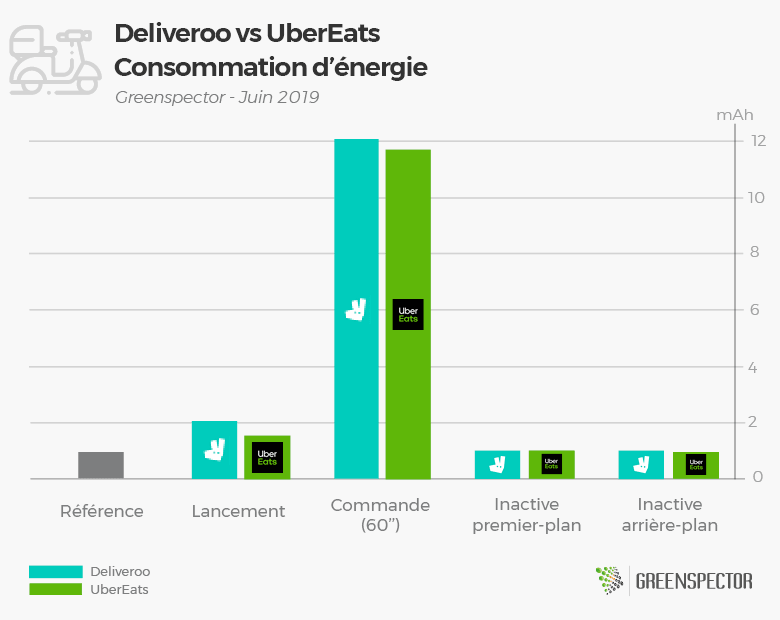

Dès le début du match, UberEats prend un net avantage sur son adversaire avec un lancement qui consomme 13% moins de batterie. Il parvient à conserver son avantage pendant la phase décisive qui consiste à commander un repas (-2,5%). La confrontation se termine par deux rounds d’observation des phases de repos de chaque adversaire, au cours desquels les deux concurrents sont à égalité.

Sur l’ensemble du match, c’est donc UberEats qui gagne aux points face à un Deliveroo qui résiste bien.

Notons que nous avons affaire ici à deux « poids lourds » qui marqueront tous deux votre batterie de leur empreinte !

Le vainqueur

Pour cette toute première battle, le match est serré mais UberEats l’emporte 15.7 mAh à 16.2 mAh devant Deliveroo, en consommant près de 3.5% moins d’énergie.

Notez quand même que l’appli Deliveroo est plus légère à télécharger et consomme moins de données – donc si vous avez un petit forfait ou une connexion réseau instable, elle peut être intéressante.

Ces deux applications peuvent être comparées sur un scénario d’une minute à la consommation en énergie d’un Netflix, elles sont également 1.6 fois plus consommatrices qu’une application telle que Spotify.

Pour ceux qui aiment les chiffres

| Application | Version | Téléchargements | Note Playstore | Poids de l’application (Mo) | Données échangées (Mo) | Mémoire (Mo) | Consommation en énergie (mAh) |

|---|---|---|---|---|---|---|---|

| Deliveroo | 3.4.1 | 5 000 000+ | 4.2 | 22 | 3.3 | 218.8 | 16.2 |

| UberEats | 1.201.10002 | 50 000 000+ | 4.2 | 31 | 3.6 | 227.7 | 15.7 |

Les mesures ont été réalisées par notre laboratoire sur la base d’un protocole standardisé, respectant un scénario utilisateur précis (lancement de l’application, sélection d’une adresse de livraison, scroll sur les pages de choix des restaurants et sélection d’un restaurant, scroll sur la page des plats et ajout dans le panier). Les autres scénarios sont le lancement de l’application (20 »), inactivité en premier-plan (20 ») et inactivité en arrière-plan (20 »).