La Solution SaaS pour valider la sobriété et la performance de vos services numériques.

Avant la release, validez la sobriété de votre application : maîtrisez sa consommation de batterie, de données, sa performance, ses impacts environnementaux, son inclusivité sociale… Grâce à un seul test dans Greenspector Studio.

Notre innovation: chaque terminal du banc de tests est équipé de sondes de mesures d’énergie très précises. Découvrez le comportement de votre application comme vous ne l’avez jamais vu, et comprenez les causes de ses problèmes.

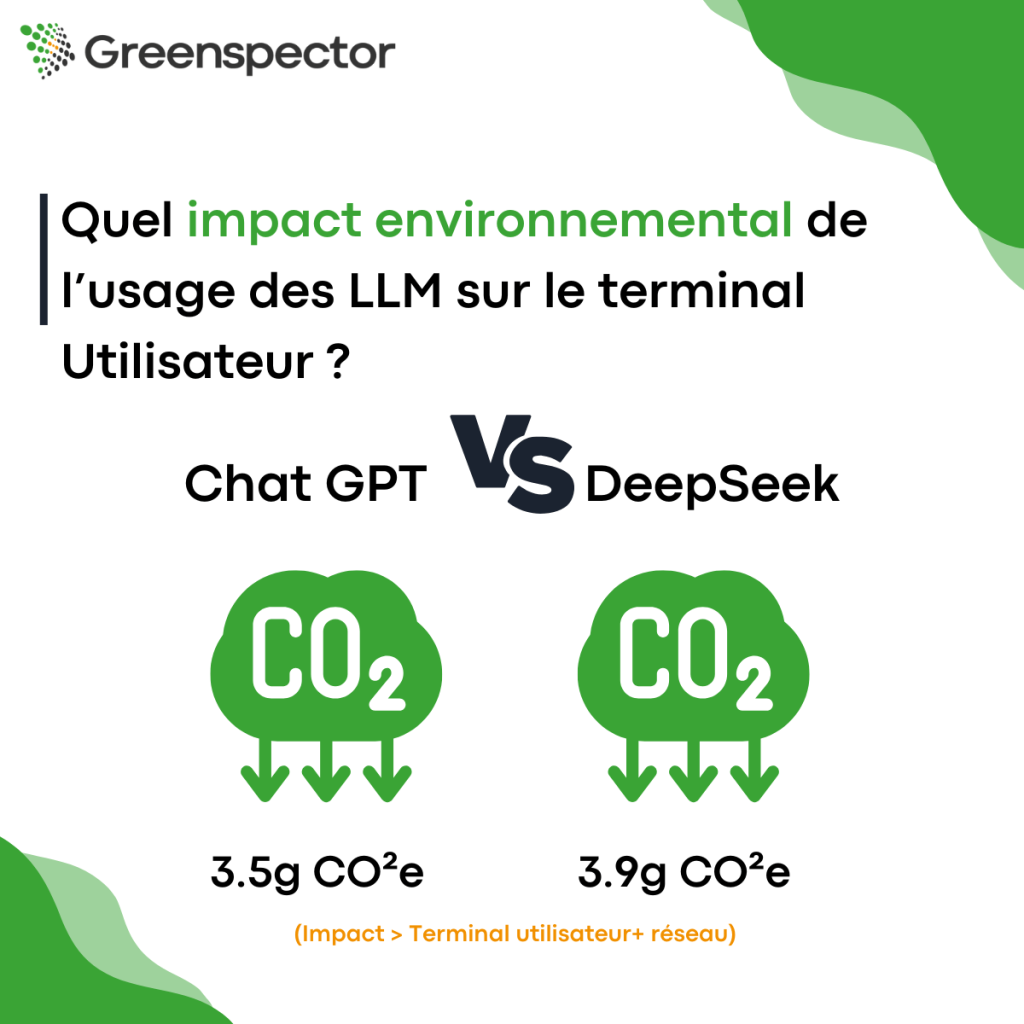

Les métriques mesurées pendant vos tests sont converties en impacts environnementaux grâce à notre modèle exclusif. CO2 et multi-critères, finement paramétrable, rigoureux et avec affichage des incertitudes, il est issu de plusieurs années de R&D.

Passez au DevGreenOps ! Greenspector Studio s’intègre facilement dans votre CI/CD grâce aux nombreuses API. Vérifiez votre écoscore et vos impacts avant chaque release, ou après chaque build.

Décrivez le parcours de vos utilisateurs en script GDSL, simplement et rapidement. Lancez le test à la main ou programmez-le depuis votre CI/CD.

Votre test se déroule sur les terminaux de notre Test Bench dans les conditions que vous avez choisies selon votre stratégie de test (gamme de terminaux, réseau WiFi ou GSM, thème clair ou sombre…).

Ecoscore, impacts environnementaux… Observez vos résultats dans l’interface web, ou utilisez nos API pour extraire les indicateurs clefs vers vos tableau de bord. Analysez les alertes et identifiez les axes de progrès !

Nos innovations sont le fruit de notre R&D. Notre contribution aux travaux scientifiques a été exposée dans de nombreux articles et conférences internationales

Notre modèle d’impacts est compatible avec les standards du domaine : ACV (ISO 14040), SCI de Green Software Foundation, RCP ADEME…

Avec Greenspector Studio, nous mesurons l’efficacité énergétique de notre application, utilisée par 7 millions de clients chaque mois, après chaque Build. Cela nous permet de réduire notre empreinte carbone, d’améliorer nos performances et de renforcer notre image de marque.

François LANKAR

Applications Manager, Bouygues Telecom

Travailler sur la sobriété permet clairement d’obtenir une application plus performante.

Julien AZRIA

Digital Front Chapter Leader, Crédit Agricole Technologie & Services

Avec Greenspector Studio, les testeurs peuvent guider les développeurs en identifiant les régressions ou les effets indésirables d’une modification.

Florence GUERLAIS

Manager, Test & QA Center of Expertise, Air France

Nos développeurs ont été sensibilisés dès le démarrage du projet et ont – petit à petit – modifié leur manière de travailler pour adopter des réflexes d’écoconception. Il s’agit d’une modification profonde des pratiques. Les indicateurs d’écoscore de Greenspector nous ont servi d’étalon tout au long de ce process.

Nicolas DESMONS

Chef d’équipe services numériques aux usagers, Région Bretagne

Il était important pour nous de pouvoir chiffrer et objectiver l’impact concret des efforts que nous allions déployer en écoconception. Grâce à l’écoscore de Greenspector, nous avons pu évaluer rationnellement le résultat de nos efforts avant et après projet. Greenspector met à disposition un outil de mesure qui permet d’évaluer l’évolution progressive des bonnes pratiques mises en place et d’identifier les réajustements nécessaires pour davantage de sobriété.

Caroline SMEYERS

Gestionnaire Web, Bruxelles Environnement / Leefmilieu Brussels

Pour s’assurer de la fiabilité maximale de l’écoscore, les équipes […] se sont appuyé sur […] Greenspector qui permet d’évaluer de façon fiable l’impact environnemental d’une application de santé. En effet, Greenspector se base sur la mesure tout au long du parcours de l’usage réel de l’application, plus que sur le simple calcul de l’impact environnemental du chargement de la page d’accueil.

Dr Brigitte SEROUSSI

Directrice de Projets, Agence du Numérique en Santé (Ministère de la Santé)